Unter Herrenmenschen — Der deutsche Kolonialismus in Namibia

Film Infos und Trailer

Zu dieser Serie ist leider

kein Trailer verfügbar.

Unter Herrenmenschen — Der deutsche Kolonialismus in Namibia

Erschienen am 2019

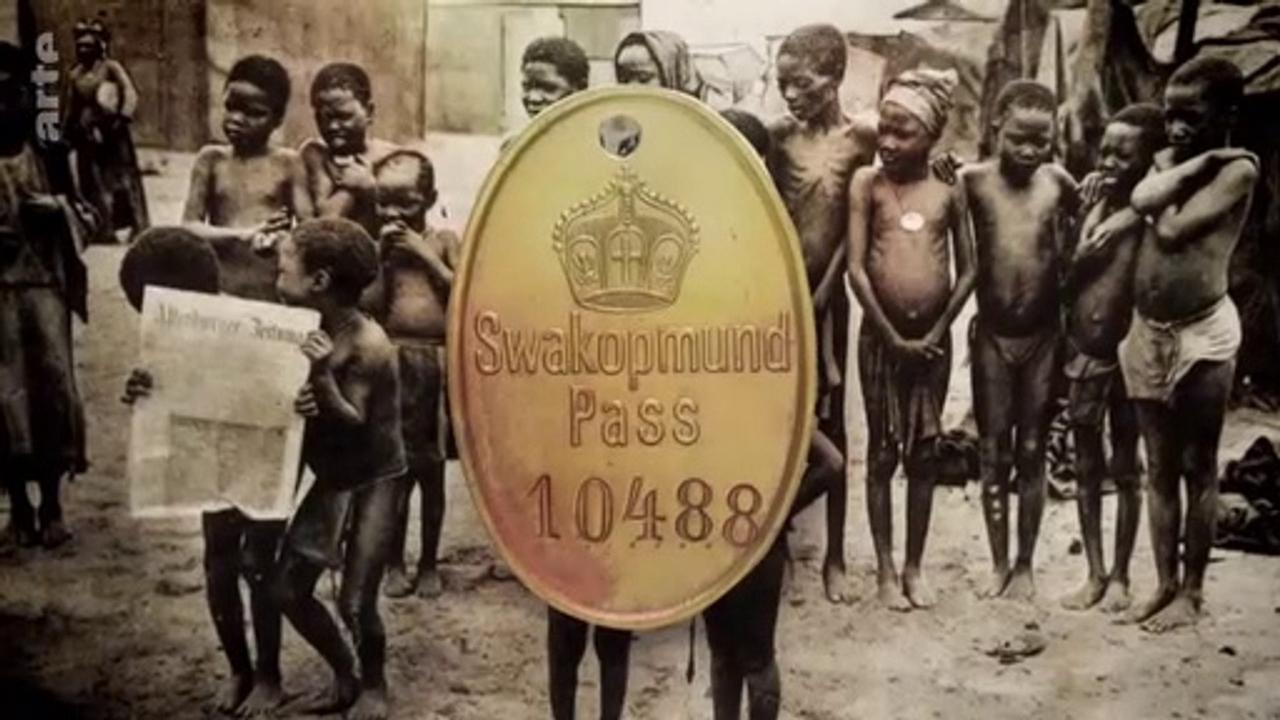

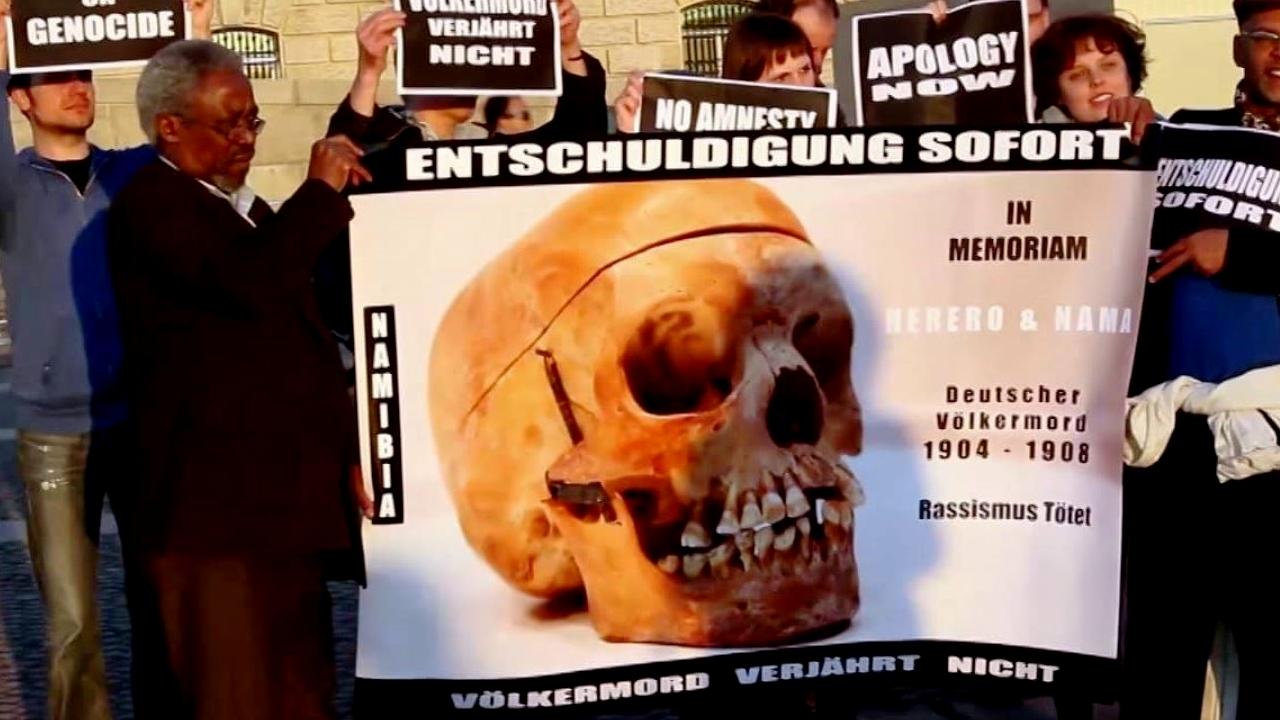

Die Deutschen kolonisierten das Land Namibia im südlichen Afrika während eines kurzen Zeitraums von 1840 bis zum Ende des Ersten Weltkriegs. Die Geschichte des so genannten Deutsch-Südwestafrikas (1884-1915) ist abscheulich; ein versteckter und verschwiegener Bericht über Plünderung und Völkermord.

Alle Bilder zu "Unter Herrenmenschen — Der deutsche Kolonialismus in Namibia":